ΟΛΟΙ ΓΝΩΡΙΖΟΥΜΕ ΠΙΑ ΟΤΙ οι φωτογραφίες που δημοσιεύουμε στα μέσα κοινωνικής δικτύωσης είναι περιεχόμενο που τα ίδια τα μέσα, δηλαδή οι αλγόριθμοί τους, αποφασίζουν αν επιτρέπεται να μοιραστεί ή αν πρέπει να «κατέβει» ή και να αποκλειστεί ο χρήστης του λογαριασμού.

Αυτά τα εργαλεία τεχνητής νοημοσύνης, που αναπτύχθηκαν από τις μεγάλες εταιρείες τεχνολογίας, συμπεριλαμβανομένων της Google και της Microsoft, προορίζονται για την προστασία των χρηστών, εντοπίζοντας βίαιες ή πορνογραφικές εικόνες, ώστε οι εταιρείες κοινωνικής δικτύωσης να μπορούν να τις αποκλείσουν. Οι εταιρείες ισχυρίζονται ότι τα δικά τους εργαλεία Τεχνητής Νοημοσύνης μπορούν επίσης να ανιχνεύσουν την «προκλητικότητα» ή το πόσο σεξουαλικά υποβλητική είναι μια εικόνα. Με αυτή την ταξινόμηση, οι πλατφόρμες –συμπεριλαμβανομένων των Instagram και LinkedIn– μπορούν να καταστείλουν αυτές τις δυνητικά ακατάλληλες εικόνες.

Αυτό το δεδομένο παρακίνησε δύο δημοσιογράφους του «Guardian» να χρησιμοποιήσουν αυτά τα εργαλεία Τεχνητής Νοημοσύνης για να αναλύσουν εκατοντάδες φωτογραφίες ανδρών και γυναικών με εσώρουχα, ρούχα γυμναστικής, φωτογραφίες μερικώς γυμνών σωμάτων κατά τη διάρκεια ιατρικών εξετάσεων, για να διαπιστώσουν κατόπιν ότι η Τεχνητή Νοημοσύνη «διάβαζε» αυτές τις φωτογραφίες ως «σεξουαλικά υποβλητικές».

Το ακόμα πιο ενδιαφέρον, όμως, ήταν ότι τις ίδιες αυτές φωτογραφίες ο αλγόριθμος έτεινε να τις «χαρακτηρίζει» σέξι, πικάντικες ή και ακατάλληλες όταν απεικόνιζαν γυναικεία σώματα.

Το αποτέλεσμα; Οι εταιρείες μέσων κοινωνικής δικτύωσης που αξιοποιούν αυτούς ή παρόμοιους αλγόριθμους έχουν περιορίσει την εμβέλεια αμέτρητων εικόνων με γυναικεία σώματα και πλήττουν τις επιχειρήσεις με επικεφαλής γυναίκες – ενισχύοντας περαιτέρω τις κοινωνικές ανισότητες.

Το αποτέλεσμα; Οι εταιρείες μέσων κοινωνικής δικτύωσης που αξιοποιούν αυτούς ή παρόμοιους αλγόριθμους έχουν περιορίσει την εμβέλεια αμέτρητων εικόνων με γυναικεία σώματα και πλήττουν τις επιχειρήσεις με επικεφαλής γυναίκες – ενισχύοντας περαιτέρω τις κοινωνικές ανισότητες.

Ακόμη και οι ιατρικές εικόνες επηρεάζονται από αυτό το ζήτημα. Οι αλγόριθμοι Τεχνητής Νοημοσύνης δοκιμάστηκαν σε εικόνες που δημοσίευσε το Εθνικό Ινστιτούτο Καρκίνου των ΗΠΑ και οι οποίες έδειχναν πώς γίνεται μια κλινική εξέταση μαστού ή μία μαστογραφία.

Για παράδειγμα, την παραπάνω φωτογραφία που απεικονίζει χέρια να ψηλαφούν τον λαιμό μιας γυναίκας –μία ξεκάθαρα ιατρικής φύσης φωτογραφία– η Τεχνητή Νοημοσύνη της Google τη βαθμολόγησε ως... «προκλητική», ενώ η Τεχνητή Νοημοσύνη της Microsoft ήταν κατά 82% σίγουρη ότι η εικόνα ήταν «ρητά σεξουαλικής φύσης» και η Amazon την κατέταξε ως αντιπροσωπευτική «γυμνή φωτογραφία».

Επίσης, οι κοιλιές των εγκύων είναι ένα πρόβλημα γι’ αυτά τα εργαλεία Τεχνητής Νοημοσύνης. Ο αλγόριθμος της Google απεφάνθη ότι είναι πολύ πιθανό αυτή η φωτογραφία «να περιέχει προκλητικό περιεχόμενο», ενώ ο αλγόριθμος της Microsoft ήταν κατά 90% βέβαιος ότι η εικόνα έκανε «υπαινιγμό σεξουαλικής φύσεως».

«Αυτό είναι απλώς τρελό», δήλωσε ο Leon Derczynski, καθηγητής πληροφορικής στο Πανεπιστήμιο Πληροφορικής της Κοπεγχάγης, ο οποίος ειδικεύεται στη βλάβη που μπορεί να προξενηθεί από το διαδίκτυο. «Η αντικειμενοποίηση των γυναικών φαίνεται να είναι βαθιά ενσωματωμένη στο σύστημα», εξηγεί.

Μια εταιρεία κοινωνικής δικτύωσης δήλωσε ότι δεν σχεδίασε τα συστήματά της ώστε να δημιουργούν ή να ενισχύουν στερεότυπα και προκαταλήψεις, ωστόσο παραδέχθηκε ότι το σύστημα ταξινόμησης που διαθέτει δεν είναι τέλειο.

«Πρόκειται για έναν πολύπλοκο και εξελισσόμενο χώρο και συνεχίζουμε να κάνουμε ουσιαστικές βελτιώσεις στα συστήματα ταξινόμησης για να διασφαλίσουμε ότι παραμένουν ακριβή και χρήσιμα για όλους», δήλωσε εκπρόσωπος της Google.

Αθόρυβος αποκλεισμός ή αλλιώς shadowban

Τον Μάιο του 2021, ο Gianluca Mauro, επιχειρηματίας Τεχνητής Νοημοσύνης, σύμβουλος και συν-συγγραφέας της μεγάλης έρευνας του «Guardian», δημοσίευσε μια ανάρτηση στο LinkedIn και εξεπλάγη όταν διαπίστωσε ότι είχε μόλις 29 προβολές μέσα σε μία ώρα, αντί για τις περίπου 1.000 προβολές που έχει συνήθως κάθε ανάρτησή του. Ίσως η εικόνα δύο γυναικών που φορούσαν εφαρμοστά τοπάκια να ήταν το πρόβλημα; Ανέβασε εκ νέου το ίδιο ακριβώς κείμενο με άλλη εικόνα. Η νέα ανάρτηση είχε 849 προβολές σε μία ώρα.

Φάνηκε ότι η ανάρτησή του είχε τεθεί σε μερικό αποκλεισμό, χωρίς φυσικά αυτό να σημαίνει κάτι για την ποιότητα του λογαριασμού του. Αυτό είναι το λεγόμενο shadowbanning, το οποίο εφαρμόζεται από τα ΜΚΔ όταν αποφασίζουν να περιορίσουν την απήχηση μιας ανάρτησης ή ενός λογαριασμού.

Ενώ μια κανονική απαγόρευση περιλαμβάνει ενεργό αποκλεισμό μιας ανάρτησης ή ενός λογαριασμού και ειδοποίηση του χρήστη, στο shadowban ο χρήστης μόνο να υποψιάζεται μπορεί ότι το ποστ του έχει «φιμωθεί» διακριτικά και φυσικά όχι με όρους διαφάνειας και άμεσης ενημέρωσης για το «πρόβλημα» που έχει δημιουργηθεί.

Ο «Guardian» στο εκτενές ρεπορτάζ του αναφέρει ότι διαπίστωσε πως η Microsoft, η Amazon και η Google προσφέρουν αλγόριθμους ελέγχου περιεχομένου σε κάθε επιχείρηση, έναντι μικρής αμοιβής. Η Microsoft, η μητρική εταιρεία και ιδιοκτήτρια του LinkedIn, δήλωσε ότι το εργαλείο της «μπορεί να ανιχνεύσει υλικό ενηλίκων σε εικόνες», «ώστε οι προγραμματιστές να μπορούν να περιορίσουν την προβολή αυτών των εικόνων στο λογισμικό τους».

The investigation found out that as a consequence of these tools labeling women’s photos as far more “racy” than men, social media companies have suppressed the visibility of countless images featuring women’s bodies, amplifying gender disparities.

— Pulitzer Center (@pulitzercenter) February 8, 2023

👉 https://t.co/bms4Zzlf4E pic.twitter.com/hYGSlsYuAq

Μετά από αυτό οι δημοσιογράφοι του «Guardian» αποφάσισαν να προχωρήσουν σε ακόμα ένα πείραμα στο LinkedIn για να διαπιστώσουν τα παραπάνω.

Πόσταραν λοιπόν δύο φωτογραφίες που απεικόνιζαν άντρες με εσώρουχα και γυναίκες επίσης με εσώρουχα. Μαντέψτε: το εργαλείο της Microsoft ταξινόμησε την εικόνα που έδειχνε δύο γυναίκες με τα εσώρουχά τους ως απόλυτα τολμηρή και τη βαθμολόγησε με 96% ποσοστό ακαταλληλότητας. Για τη φωτογραφία ανδρών με εσώρουχα, το εργαλείο βαθμολόγησε με μόλις 14% ποσοστό ακαταλληλότητας...

Η φωτογραφία με τις γυναίκες είχε οκτώ προβολές μέσα σε μία ώρα, ενώ η φωτογραφία με τους δύο άνδρες είχε 655 προβολές, γεγονός που υποδηλώνει ότι η φωτογραφία με τις γυναίκες με εσώρουχα υπέστη shadowban με συνοπτικές διαδικασίες. Η διαδικασία του shadowbanning έχει τεκμηριωθεί ως πρακτική εδώ και χρόνια, ωστόσο οι δημοσιογράφοι του «Guardian» ίσως βρήκαν έναν χαμένο κρίκο για την κατανόηση του φαινομένου: προκατειλημμένους αλγόριθμους Τεχνητής Νοημοσύνης.

Οι πλατφόρμες κοινωνικής δικτύωσης φαίνεται να αξιοποιούν αυτούς τους αλγόριθμους για να βαθμολογούν εικόνες και να περιορίζουν την απήχηση του περιεχομένου που θεωρούν υπερβολικά τολμηρό, προσβλητικό ή επικίνδυνο. Το πρόβλημα φαίνεται να είναι ότι αυτοί οι αλγόριθμοι Τεχνητής Νοημοσύνης έχουν ενσωματωμένη μεροληψία ως προς το φύλο, βαθμολογώντας τις γυναίκες απείρως πιο αυστηρά από τους άνδρες.

«Οι ομάδες μας χρησιμοποιούν έναν συνδυασμό αυτοματοποιημένων τεχνικών, ανθρώπινων αξιολογήσεων από εμπειρογνώμονες και αναφορών μελών για να βοηθήσουν στον εντοπισμό και την αφαίρεση περιεχομένου που παραβιάζει τις πολιτικές της επαγγελματικής μας κοινότητας», δήλωσε ο εκπρόσωπος του LinkedIn, Fred Han.

«Επιπλέον, η ροή μας χρησιμοποιεί τους αλγόριθμους με υπευθυνότητα, προκειμένου να αναδείξει περιεχόμενο που βοηθά τα μέλη μας να είναι πιο παραγωγικά και επιτυχημένα στο επαγγελματικό τους ταξίδι στην πλατφόρμα μας». Άλλα λόγια ν’ αγαπιόμαστε, κοινώς.

Η Amazon ανέφερε ότι ο έλεγχος του περιεχομένου βασίζεται σε διάφορους παράγοντες, όπως η γεωγραφία, οι θρησκευτικές πεποιθήσεις και η πολιτιστική εμπειρία. Ωστόσο, «το Amazon Rekognition είναι σε θέση να αναγνωρίζει μια μεγάλη ποικιλία περιεχομένου, αλλά δεν καθορίζει την καταλληλότητα αυτού του περιεχομένου», δήλωσε εκπρόσωπος του τεχνολογικού κολοσού. «Η υπηρεσία απλώς επιστρέφει τις αναφορές για όσα ακατάλληλα εντοπίζει για περαιτέρω αξιολόγηση από συντονιστές ανθρώπους και όχι bots».

Ψάχνοντας βαθύτερα

Η Natasha Crampton, υπεύθυνη για την Τεχνητή Νοημοσύνη της Microsoft, μαζί με την ομάδα της άρχισαν να ερευνούν το ζήτημα, όταν ενημερώθηκαν για τα ευρήματα των δημοσιογράφων του βρετανικού Μέσου.

«Τα αρχικά αποτελέσματα δεν δείχνουν ότι αυτά τα ψευδώς θετικά αποτελέσματα εμφανίζονται σε δυσανάλογα υψηλότερο ποσοστό για τις γυναίκες σε σύγκριση με τους άνδρες», δήλωσε η Crampton. Αυτό όμως άλλαξε, όταν το εργαλείο Τεχνητής Νοημοσύνης χρειάστηκε να «διαβάσει» κι άλλες φωτογραφίες. Και συν τοις άλλοις είχε αλλάξει και το landing page της διαδικασίας. Πριν από τον εντοπισμό του προβλήματος, ήταν δυνατή η δοκιμή των αλγορίθμων με ένα απλό drag and drop (η διαδικασία του να μεταφέρεις μια φωτογραφία μέσα σε ένα αρχείο ή μία εφαρμογή). Τώρα έπρεπε να δημιουργηθεί ένας λογαριασμός και να γραφτεί κώδικας.

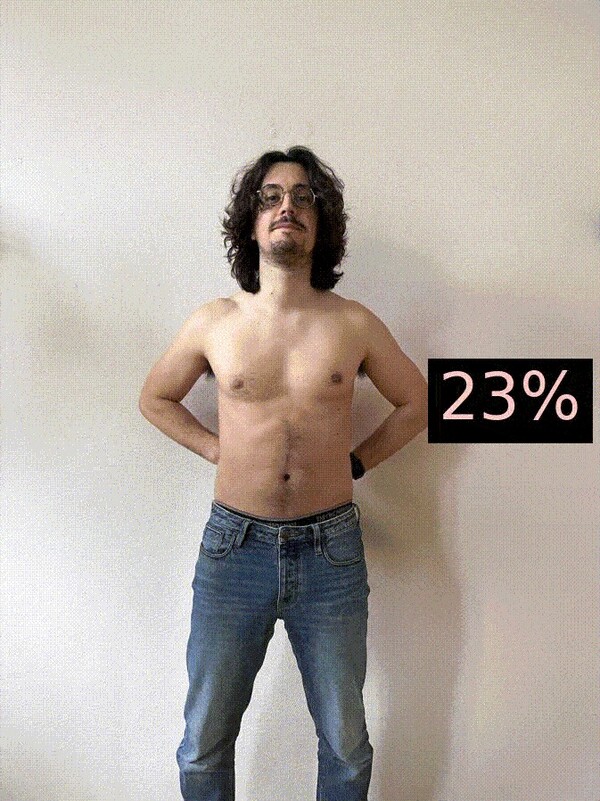

Αλλά τι αναλύουν στην πραγματικότητα αυτοί οι ταξινομητές τεχνητής νοημοσύνης; Τι πραγματικά «διαβάζουν» στις φωτογραφίες; Χρειάζονταν περισσότερα πειράματα, οπότε ο Mauro συμφώνησε να γίνει το πειραματόζωο.

Όταν φωτογραφήθηκε με μακρύ παντελόνι και με γυμνό στήθος, ο αλγόριθμος της Microsoft τον βαθμολόγησε με 22% ποσοστό ακαταλληλότητας. Όταν, όμως, φόρεσε σουτιέν, η ακαταλληλότητα της φωτογραφίας άγγιξε το 97%. Ο αλγόριθμος τον φιλοδώρησε με ένα 99%, όταν απλώς κράτησε το σουτιέν μπροστά στην κάμερα.

«Το εργαλείο εξετάζει πληροφορίες χωρίς πλαίσιο, όπου ένα σουτιέν θεωρείται ως εγγενώς ακατάλληλο και όχι ως ένα αντικείμενο που πολλές γυναίκες φορούν καθημερινά ως βασικό ρούχο», δήλωσε η Κέιτ Κρόφορντ, καθηγήτρια στο Πανεπιστήμιο της Νότιας Καλιφόρνιας και συγγραφέας του «Atlas of AI».

Η Abeba Birhane, ανώτερη συνεργάτις στο Ίδρυμα Mozilla και ειδικός σε μεγάλα οπτικά σύνολα δεδομένων, δήλωσε ότι η προκλητικότητα και η ακαταλληλότητα είναι κοινωνικές έννοιες που διαφέρουν από πολιτισμό σε πολιτισμό.

«Αυτές οι έννοιες δεν είναι σαν την αναγνώριση ενός τραπεζιού, όπου έχεις μπροστά σου το φυσικό αντικείμενο και μπορείς να έχεις έναν σχετικά αποδεκτό ορισμό ή βαθμολογία για ένα συγκεκριμένο πράγμα. Απλώς δεν μπορείς να έχεις έναν ενιαίο, αδιαμφισβήτητο ορισμό περί προκλητικότητας».

Όμως, γιατι αυτά τα συστήματα φαίνονται τόσο προκατειλημμένα με τις γυναίκες, για να μην πούμε απολύτως σεξιστικά διακείμενα απέναντί τους;

Η σύγχρονη Τεχνητή Νοημοσύνη κατασκευάζεται με τη χρήση μηχανικής μάθησης, ένα σύνολο αλγορίθμων που επιτρέπουν στους υπολογιστές να μαθαίνουν από τα δεδομένα. Όταν οι προγραμματιστές χρησιμοποιούν τη μηχανική μάθηση, δεν γράφουν ρητούς κανόνες που λένε στους υπολογιστές πώς να εκτελέσουν μια εργασία. Αντ' αυτού, παρέχουν στους υπολογιστές δεδομένα εκπαίδευσης. Οι άνθρωποι προσλαμβάνονται για να χαρακτηρίζουν τις εικόνες, ώστε οι υπολογιστές να μπορούν να αναλύσουν τα αποτελέσματά τους και να βρουν οποιοδήποτε μοτίβο τους βοηθά να αναπαράγουν τις ανθρώπινες αποφάσεις.

Η Μάργκαρετ Μίτσελ πιστεύει ότι οι φωτογραφίες που χρησιμοποιήθηκαν για την εκπαίδευση αυτών των αλγορίθμων πιθανώς χαρακτηρίστηκαν από στρέιτ άνδρες, οι οποίοι μπορεί να συνδέουν τους άνδρες που γυμνάζονται με τη γυμναστική, αλλά μπορεί να θεωρούν την εικόνα μιας γυναίκας που γυμνάζεται ως «σεξουαλική».

Η Μάργκαρετ Μίτσελ, επικεφαλής επιστήμονας ηθικής στην εταιρεία Τεχνητής Νοημοσύνης Hugging Face και πρώην συν-επικεφαλής της ερευνητικής ομάδας ηθικής τεχνητής νοημοσύνης της Google, πιστεύει ότι οι φωτογραφίες που χρησιμοποιήθηκαν για την εκπαίδευση αυτών των αλγορίθμων πιθανώς χαρακτηρίστηκαν από στρέιτ άνδρες, οι οποίοι μπορεί να συνδέουν τους άνδρες που γυμνάζονται με τη γυμναστική, αλλά μπορεί να θεωρούν την εικόνα μιας γυναίκας που γυμνάζεται ως «σεξουαλική».

Είναι επίσης πιθανό ότι αυτές οι αξιολογήσεις φαίνονται μεροληπτικές ως προς το φύλο στις ΗΠΑ και στην Ευρώπη, επειδή αυτοί που χαρακτήρισαν τις εικόνες πολύ πιθανώς να προέρχονταν από χώρες με πιο συντηρητική κουλτούρα.

Ιδανικά, οι εταιρείες τεχνολογίας θα έπρεπε να έχουν πραγματοποιήσει ενδελεχείς αναλύσεις σχετικά με το ποιος χαρακτηρίζει τα δεδομένα τους, ώστε να διασφαλίσουν ότι το τελικό σύνολο δεδομένων ενσωματώνει μια ποικιλία απόψεων, δήλωσε η ίδια. Οι εταιρείες θα έπρεπε επίσης να ελέγχουν ότι οι αλγόριθμοί τους αποδίδουν παρόμοια σε φωτογραφίες ανδρών έναντι εκείνων γυναικών και άλλων ομάδων, αλλά αυτό δεν γίνεται πάντα. Αλλά, όπως επισήμανε και η Μίτσελ «δεν υπάρχει κανένα πρότυπο ποιότητας εδώ».

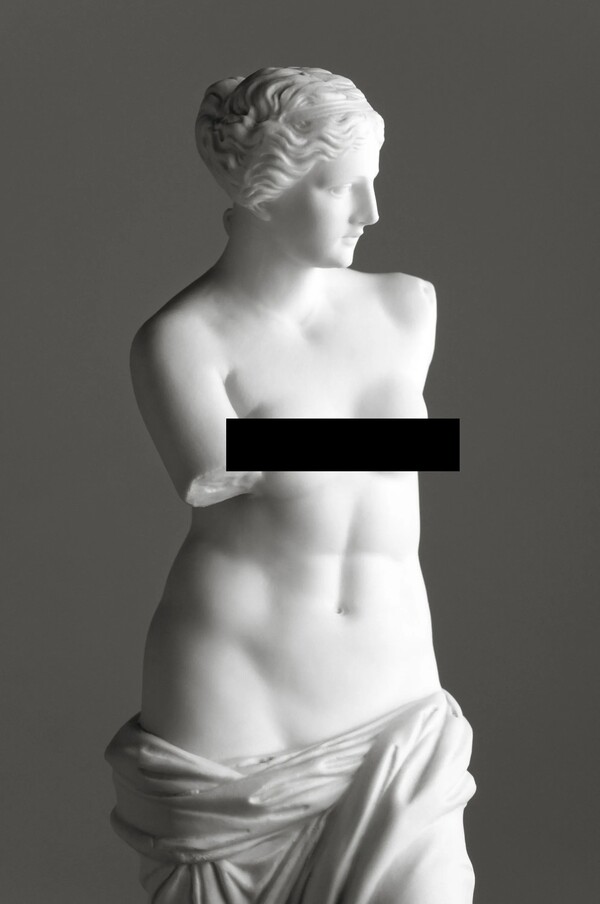

Αυτή η έμφυλη προκατάληψη που αποκάλυψε ο «Guardian» αποτελεί μέρος μιας δεκαετούς και πλέον διαμάχης γύρω από τον έλεγχο του περιεχομένου στα μέσα κοινωνικής δικτύωσης. Οι εικόνες που δείχνουν γυναίκες να θηλάζουν τα παιδιά τους και τα διπλά standards για τις φωτογραφίες ανδρικών θηλών, οι οποίες επιτρέπονται στο Instagram, και γυναικείων θηλών, που πρέπει να καλύπτονται με λουλουδάκια και αστεράκια, έχουν εδώ και καιρό προκαλέσει σοβαρές αντιδράσεις σχετικά με τις πρακτικές ελέγχου περιεχομένου των μέσων κοινωνικής δικτύωσης.

Τώρα το εποπτικό συμβούλιο της Meta –ένα εξωτερικό όργανο που περιλαμβάνει καθηγητές, ερευνητές και δημοσιογράφους, οι οποίοι πληρώνονται από την εταιρεία– ζήτησε από τον τεχνολογικό γίγαντα να αποσαφηνίσει τις κατευθυντήριες γραμμές του για το γυμνό ενηλίκων και τη σεξουαλική δραστηριότητα στις πλατφόρμες κοινωνικής δικτύωσης, «έτσι ώστε όλοι οι άνθρωποι να αντιμετωπίζονται με τρόπο που να συνάδει με τα διεθνή πρότυπα ανθρωπίνων δικαιωμάτων, χωρίς διακρίσεις λόγω φύλου». Η Meta, πάντως, αρνήθηκε να κάνει κάποιο σχετικό σχόλιο στον «Guardian».

Οι γυναίκες πρέπει να εκφράζονται

Η Bec Wood, μια 38χρονη φωτογράφος με έδρα το Περθ της Αυστραλίας, δηλώνει ότι φοβάται την «αλγοριθμική αστυνομία» του Instagram.

Όταν απέκτησε μια κόρη πριν από εννέα χρόνια, άρχισε να μελετά την εκπαίδευση γύρω από τον τοκετό και να φωτογραφίζει γυναίκες προσπαθώντας να αντισταθεί στις κοινωνικές πιέσεις που κάνουν πολλές γυναίκες να αισθάνονται ότι πρέπει να μοιάζουν με super model μετά τη γέννα.

«Οι γυναίκες πρέπει να εκφράζονται και να αγαπούν και να γιορτάζουν το σώμα τους, και να είναι ορατές με όλα τα κιλά και τα μεγέθη που παίρνει το γυναικείο σώμα. Είναι σημαντικό να το καταλάβουμε αυτό, για να πάμε μπροστά», λέει η ίδια.

Οι φωτογραφίες της Wood ουσιαστικά είναι η προσωπική της ματιά πάνω στις σχέσεις των γυναικών με τους απογόνους τους. Φωτογραφίζει τον θηλασμό, την εγκυμοσύνη και άλλες σημαντικές στιγμές στη ζωή μιας γυναίκας με καλλιτεχνικό τρόπο. Η επιχείρησή της εξαρτάται 100% από το Instagram. «Εκεί σε βρίσκει ο κόσμος. Αν δεν μοιράζομαι τη δουλειά μου, δεν δουλεύω και δεν με βρίσκουν νέοι πελάτες», εξηγεί.

Από τότε που η Wood ξεκίνησε την επιχείρησή της το 2018, δεν ήταν λίγες οι φορές που είδε φωτογραφίες της να «κατεβαίνουν» από τον λογαριασμό της μετά τις σχετικές ειδοποιήσεις του Instagram για παραβίαση της πολιτικής του.

Ήλπιζε ότι το Instagram θα διόρθωνε το ζήτημα με την πάροδο του χρόνου, αλλά συνέβη το αντίθετο. «Ειλικρινά δεν μπορώ να πιστέψω ότι όλο αυτό έγινε χειρότερο. Έχει καταστρέψει την επιχείρησή μου», εξηγεί η Wood, που περιγράφει το 2022 ως τη χειρότερη χρονιά της από επιχειρηματικής άποψης.

Όπως λέει, τρέμει ότι, αν ανεβάσει τη «λάθος» εικόνα, το Instagram θα την κλειδώσει έξω από τον λογαριασμό της με πάνω από 13.000 followers, κάτι που θα κάνει την επιχείρησή της να χρεοκοπήσει. «Κυριολεκτικά φοβάμαι τόσο πολύ να ποστάρω γιατί σκέφτομαι: "Είναι αυτή η ανάρτηση που θα μου τα διαλύσει όλα;"». Για να αποφύγει ένα τέτοιο ενδεχόμενο, η Wood άρχισε να πηγαίνει κόντρα σε αυτό που την έκανε να ξεκινήσει τη δουλειά της εξαρχής. Άρχισε, για παράδειγμα, να «λογοκρίνει» τις θηλές των γυναικών.

«Θα το κάνω όσο πιο καλλιτεχνικά μπορώ. Αλλά το βρίσκω τόσο προσβλητικό για την τέχνη, και κυρίως για τις γυναίκες. Σχεδόν αισθάνομαι ότι είμαι μέρος της διαιώνισης αυτού του γελοίου κύκλου στον οποίο δεν θέλω να έχω καμία συμμετοχή», λέει.

Ξαναμαντέψτε: όταν οι δημοσιογράφοι του «Guardian» πέρασαν τις φωτογραφίες της Wood από τα εργαλεία Τεχνητής Νοημοσύνης της Microsoft, της Google και της Amazon, συμπεριλαμβανομένων εκείνων που απεικόνιζαν έγκυες, εννοείται ότι αυτές αξιολογήθηκαν ως «πικάντικες», γυμνές ή ακόμη και σεξουαλικές.

Η Wood δεν είναι η μόνη. Η Carolina Are, εμπειρογνώμονας στις πλατφόρμες κοινωνικής δικτύωσης και συνεργάτιδα καινοτομίας στο Centre for Digital Citizens του Πανεπιστημίου Northumbria, δήλωσε ότι έχει χρησιμοποιήσει το Instagram για να προωθήσει την επιχείρησή της και έπεσε θύμα του shadowbanning.

Η Are, εκπαιδεύτρια pole dancing, δήλωσε ότι κάποιες από τις φωτογραφίες της «κατέβηκαν» και το 2019 ανακάλυψε ότι οι φωτογραφίες της δεν εμφανίζονταν υπό το hashtag #FemaleFitness, όπου οι χρήστες του Instagram μπορούν να αναζητήσουν περιεχόμενο από χρήστες που δεν ακολουθούν. «Ήταν κυριολεκτικά μόνο γυναίκες που γυμνάζονταν με πολύ σεμνό τρόπο. Αλλά στη συνέχεια, αν κοιτάζατε στο hashtag #MaleFitness, ήταν εκεί όλοι οι λαδωμένοι σφίχτες και ήταν μια χαρά. Αυτοί δεν είχαν υποστεί shadowbanning», τονίζει.

Για την Are αυτά τα μεμονωμένα προβλήματα υποδεικνύουν μεγαλύτερα συστημικά προβλήματα: πολλοί άνθρωποι, συμπεριλαμβανομένων των χρονίως πασχόντων και των ατόμων με αναπηρία, βασίζονται στο να βγάζουν χρήματα μέσω των κοινωνικών μέσων και το shadowbanning βλάπτει τις επιχειρήσεις τους.

«Αυτό σημαίνει ότι οι άνθρωποι που τείνουν να περιθωριοποιούνται, περιθωριοποιούνται ακόμη περισσότερο, με μια πολύ άμεση έννοια του όρου», συμφωνεί η Μίτσελ.

Και όλες συμφωνούν ότι για να υπάρξει ένα ασφαλέστερο μέλλον για την Τεχνητή Νοημοσύνη, χρειαζόμαστε την εξασφάλιση της γυναικείας προοπτικής και εκπροσώπησης σε περιβάλλον Τεχνητής Νοημοσύνης.

Για τη Μίτσελ, το ζητούμενο είναι όλο αυτό να μη συνεχιστεί και να πάψει αυτού του είδους η πίεση προς τις γυναίκες. «Όλο αυτό έχει γίνει κανόνας. Και πρέπει να αλλάξει», καταλήγει.